Mindestens einmal im Monat darf ich Online- oder Präsenzseminare zum Thema Künstliche Intelligenz für Verbraucher halten. Die Entwicklungen in diesem Bereich sind rasant und im Grunde gibt es Woche für Woche Neuigkeiten zu berichten. Daher auch mein kostenloser wöchentlicher Newsletter.

Jetzt bekam ich einen Kommentar von Freshworks auf den Tisch, die mir wieder bewusst machen, wie weit der Handel mit dem Thema KI in der Praxis ist. Wir sprechen dabei nicht von Science Fiction, sondern von der Realität. Im Mittelpunkt steht die Kundenpersonalisierung, also Daten, Daten, Daten als Zauberwort und Türöffner. Im Moment recherchiere ich zum neuen AI Data-Act der EU in einem Spannungsfeld zwischen Datenschutz und Innovationshemmnis.

Unternehmen setzen vermehrt auf KI-Techniken wie maschinelles Lernen, um Kundenverhalten, Stimmungen, demografische Daten und Kaufhistorien zu analysieren und dadurch personalisierte Erlebnisse zu schaffen. Diese Entwicklung zeigt bereits jetzt messbare Ergebnisse, wobei laut NewVantage Partners 92 % der Unternehmen, die in KI investieren, messbare Erfolge verzeichnen – im Vergleich zu 48 % vor fünf Jahren.

Personalisierung der Inhalte

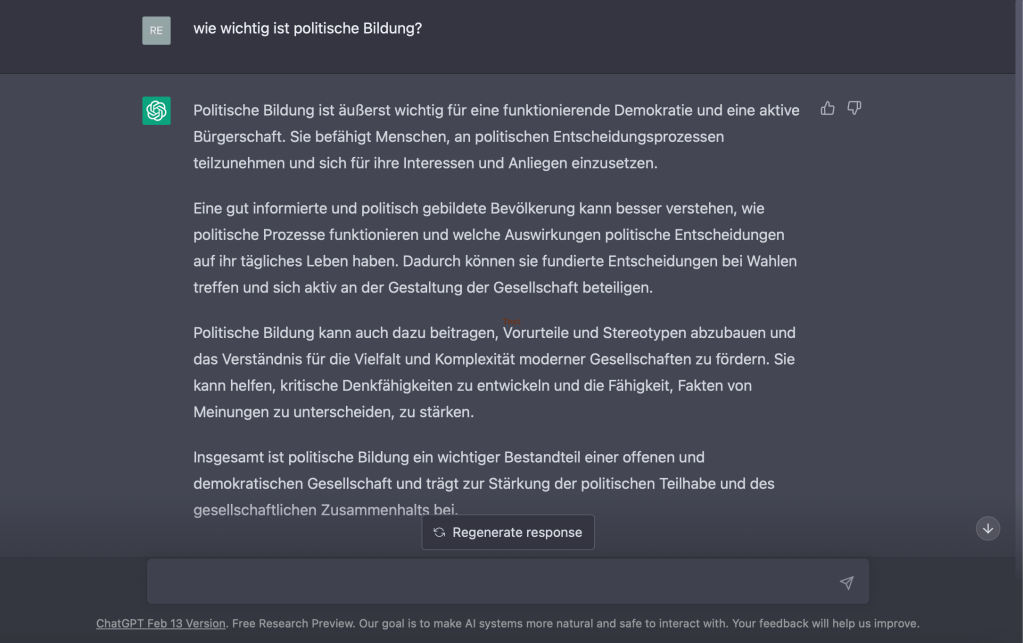

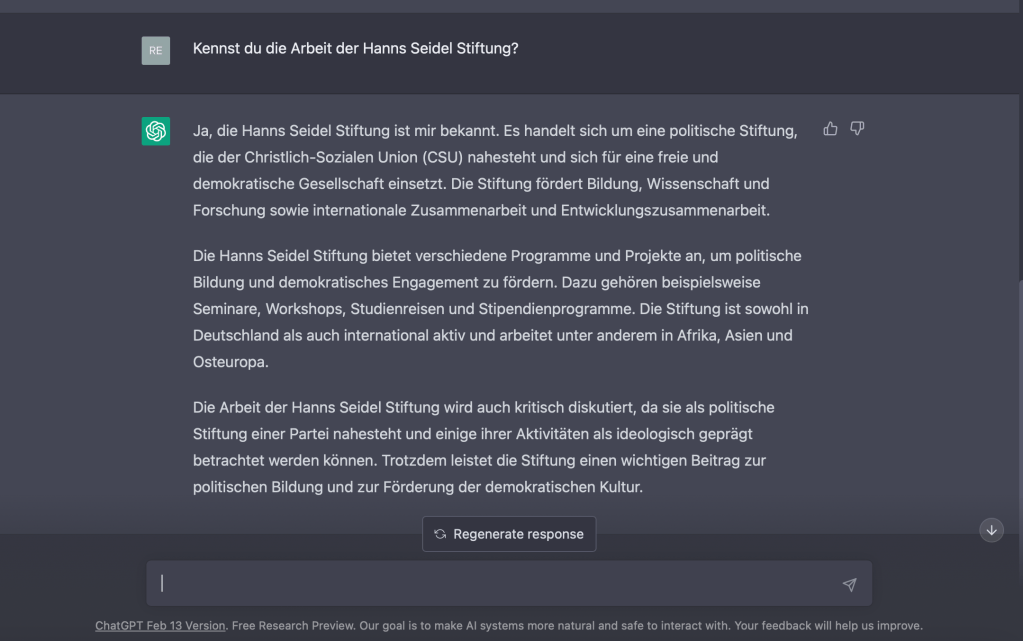

Traditionelle Marketing-Personalisierung basiert auf einer Persona-basierten Segmentierung, die Nutzer anhand allgemeiner demografischer Merkmale wie Alter, Einkommen und Beruf in Gruppen einteilt. Diese Daten sind jedoch oberflächlich und berücksichtigen nicht die individuellen Leidenschaften und Lebensstile. Ich kenne aber viele Organisationen, die Persona jetzt erst einsetzen.

KI-Algorithmen analysieren detaillierte und umfangreiche Daten, darunter demografische Informationen, Seitenaufrufe und Downloads. Diese Daten ermöglichen es Unternehmen, Muster zu erkennen und Inhaltsstrategien präziser auf einzelne KundInnen zuzuschneiden. Ein Beispiel ist Spotify, das maschinelles Lernen nutzt, um personalisierte Musikinhalte basierend auf der individuellen Streaming-Historie zu liefern. Besonders in Branchen wie Medien und Unterhaltung, in denen Inhalte das Hauptprodukt sind, spielt die personalisierte Content-Strategie eine entscheidende Rolle.

Empfehlungen für Produkte

Unternehmen nutzen die Online-Suchhistorie, um Produktkategorien für Kunden mit ähnlichem Suchverhalten zu verstehen, stoßen jedoch oft an Grenzen bei der Empfehlung neuer Produkte. KI verwendet nicht nur Kundendaten, sondern erfordert auch genauere Produktmodelle. Durch detaillierte Produktinformationen, einschließlich Bedienungsanleitungen und einzigartiger Merkmale, kann KI personalisierte Produktvorschläge erstellen, die die individuellen Bedürfnisse der KundInnen besser ansprechen. E-Commerce-Unternehmen setzen KI ein, um Produkte mithilfe neuronaler Netze basierend auf Bildern und Texten zu analysieren, was zu genaueren und persönlicheren Produktempfehlungen führt.

Dynamische Preisgestaltung

Traditionelle Regelbasierte Preisgestaltungssysteme stützen sich auf langsame Informationen und historische Daten, was zu reaktiven Preisentscheidungen führt. KI-gestützte Systeme passen Preise in Echtzeit an, indem sie eine Vielzahl von Datenquellen berücksichtigen, von Wetterbedingungen bis hin zur persönlichen Historie des Kunden oder der Kundin. Besonders in volatilen Branchen wie dem Transportwesen spielt die KI-gesteuerte dynamische Preisgestaltung eine entscheidende Rolle.

Verhaltensbasierte Personalisierung

Die Kaufhistorie allein bietet begrenzte Einblicke in das Kundenverhalten. KI ermöglicht Echtzeitdatenerfassung über digitale Telemetrie, Website-Navigation und Stimmungsanalyse, was eine prädiktive Analyse des Kundenverhaltens ermöglicht. Branchen, die mit Online-Nutzern interagieren, profitieren von der verhaltensbasierten Personalisierung, sei es im Kundensupport von Mobilfunkanbieteren oder in der Finanzdienstleistungsbranche, die individuelle Bedürfnisse besser verstehen möchte.

Insgesamt hat die Einführung von KI-basierten Personalisierungstechnologien das Potenzial, das Kundenerlebnis zu revolutionieren und Unternehmen näher an ihre Kunden zu bringen als je zuvor.